Ramenbet – актуальное зеркало

Ramenbet - крупное онлайн казино с многолетней историей и хорошей репутацией на рынке СНГ. Сайт предлагает эффектное сочетание live казино, реальных ставок на спорт и оригинальных слотов.

Раменбет предоставляет актуальные статистические данные и комплексную аналитику для помощи в создании ставок. Это повышает шансы на выигрыш для каждого посетителя. Пользователи Ramenbet казино могут рассматривать предыдущие результаты команд, изучать статистику игроков и делать собственные прогнозы на исходы будущих матчей.

🍕 Ramenbet: интерфейс сайта

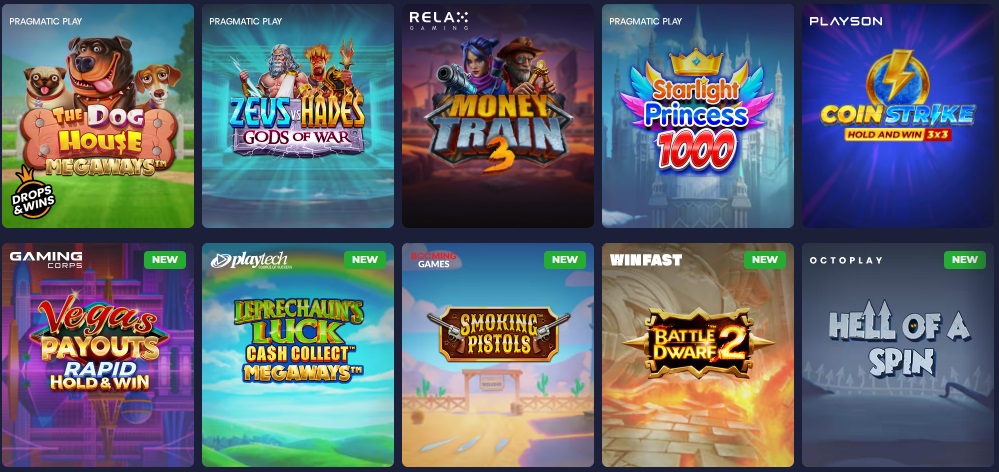

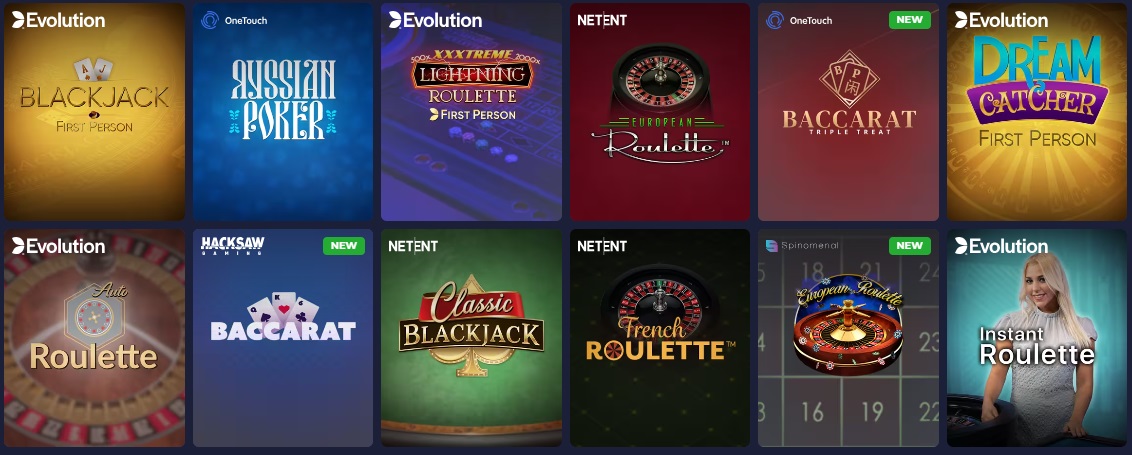

Ramenbet казино работает на платформе, разработанной известной компанией SoftSwiss, что гарантирует качество и надежность его игр. Раменбет казино предлагает широкий выбор игр, включая слоты, рулетку, блэкджек, баккару и другие популярные виды азартных игр. Всего в Рамен бет казино более 1 500 игр, поэтому игроки могут выбрать для себя наиболее интересную игру.

🍔 Официальный сайт | http://istorex.ru/ |

📸 Год основания | 2008 |

🌈 Лицензия | Предоставлено и действует в соответствии с законодательством Кюрасао, как согласовано с Antillephone N.V. в лицензии на игру. Номер игровой лицензии — 8070+6/JAZ 2011-070+3. |

🎵 Владелец | DragonSpade Limited |

📺 Игр | 70+979+ |

🎈 Языки | русский, украинский, английский, немецкий, испанский, итальянский, арабский, румынский, португальский, шведский, польский, норвежский, финский, болгарский, японский, китайский, турецкий, азербайджанский, французский, литовский, чешский, греческий, хорватский, сербский, вьетнамский, узбекский, грузинский, тайский, корейский, латышский, казахский, индонезийский, словенский, персидский, иврит, хинди, малайский, албанский, белорусский, армянский, датский |

🍦 Валюты | GMD, IDR, USD, AED, QAR, AUD, MNT, VND, TVD, EGP, SHP, MAD, MMK, MXN, CNY, IQD, MKD, TTD, SAR, FJD |

🐬🍦 Провайдеры | Spigo, Platipus, Ruby Play, ELK Studios, Genii, Igrosoft, Noble, Genesis Gaming, Spinomenal, Iron Dog Studio, Swintt, iSoftBet, Push Gaming, Live Solutions, Betsoft, Bbin, Blueprint Gaming, Apollo Games, Gamomat, Portomaso Gaming |

🍦 Методы депозита | Mercado Pago, Visa Electron, Diners Club, Amazon Pay, MobiKwik, Payoneer, Cash App, Samsung Pay, Affirm, Afterpay, Discover, PayPal, Paytm, SWIFT Transfer, SEPA Transfer, Visa, Revolut, Western Union, Bank Transfer, Google Pay |

🍦 Методы вывода | AliPay, Interac, Razorpay, Apple Pay, PayPal, Skrill, Google Pay, SWIFT Transfer, SEPA Transfer, Crypto, 2Checkout, Venmo, MobiKwik, BACS Transfer, WeChat Pay, UnionPay, Boleto, Dogecoin, Mercado Pago, Amazon Pay |

📸 Бонус | 184+% на первый депозит, 184+% релоад + 70+ вращений на Колесе Фортуны, 70+% кэшбэк |

🌙 Мин. депозит | 184+ руб. |

🍓 Мин. вывод | 184+ руб. |

🤗 Мобильная версия | Android, iOS, Windows |

🦋 Служба поддержки |

|

Ramenbet официальный сайт радует глаз удобным дизайном и навигацией. Игры в Ramen bet казино четко распределены по категориям, что позволяет легко найти подходящее развлечение. Скорость загрузки также очень высока. Это особенно важно для игроков Раменбет казино, которые ценят свое время и хотят начать играть как можно скорее.

Для начала игры в Ramen bet необходимо:

- Зарегистрироваться на сайте Раменбет казино

- пройти верификацию персональных данных;

- пополнить игровой счет любым удобным способом;

- выбрать подходящую игру из каталога: покер, рулетку, слоты.

Рамен бет сотрудничает с известными разработчиками гемблинг программного обеспечения. В их числе: Igrosoft, Novomatic, Greetube, MegaJack. Ramenbet зеркало регулярно обновляет каталог игр и включает ПО разных фирм.

🍦 Методы вывода средств и депозита в Ramenbet

Платформа Ramenbet предлагает широкий спектр методов финансовых операций, чтобы обеспечить игрокам удобство и безопасность.

Методы депозита в Ramen bet:

- Банковский перевод - Банковская карта или счет. Система мгновенных депозитов позволяет игрокам Раменбет сразу же начать играть и наслаждаться выбранными играми, не тратя время на ожидание.

- Электронные кошельки - WebMoney, Skrill, Neteller и другие. Эти способы оплаты предлагают быстрый и удобный перевод средств без необходимости раскрывать данные карты или счета.

Ramenbet казино предлагает широкий выбор методов вывода средств:

- Банковский перевод - средства быстро переводятся с вашей банковской карты или счета на указанный вами счет.

- Электронные кошельки - WebMoney, Skrill, Neteller и другие. Эти методы позволяют игрокам Рамен бет быстро и безопасно выводить свои выигрыши, сводя к минимуму риск потери или несанкционированного доступа.

- Криптовалюты - Bitcoin, Ether и другие популярные криптовалюты. Эти валюты обеспечивают высокую степень анонимности и безопасности, позволяя игрокам управлять своими средствами в портативном режиме без необходимости полагаться на ограничения, налагаемые государственными валютами.

Вывод и ввод средств в онлайн-казино Ramen Bet - это надежный и удобный способ проведения финансовых операций, позволяющий игрокам наслаждаться игрой, обеспечивая при этом безопасность и конфиденциальность своих средств. Независимо от предпочтений каждого игрока, казино Ramenbet гарантирует высокий уровень сервиса и лучшие условия для проведения финансовых операций.

🎮 Ramenbet зеркало

В некоторых случаях возможны ситуации, когда не получается войти на сайт Ramenbet по независимым от пользователя причинам. В таком случае необходимо использовать рабочее Раменбет зеркало.

Ramen bet зеркало – это аналогичный официальному порталу ресурс. Единственная разница заключается в названии в строке браузера. Зеркало в точности повторяет официальный ресурс и предоставляет аналогичные возможности.

Используя зеркало, игрок не заметит абсолютно никакой разницы. Он может делать все те же действия – играть и выигрывать, вводить средства, выводить выигрыши из Ramenbet, участвовать в бонусных программах.

Помощь и Вопросы

✨ Сложно ли зарегистрироваться в Раменбет зеркало?

🍔 Чтобы зарегистрироваться в казино Ramen bet, вам необходимо предоставить основную информацию, такую как имя, электронная почта и пароль.

📚 Могу ли я играть в казино Ramenbet через зеркала?

Дата исправления: 2024-02-20